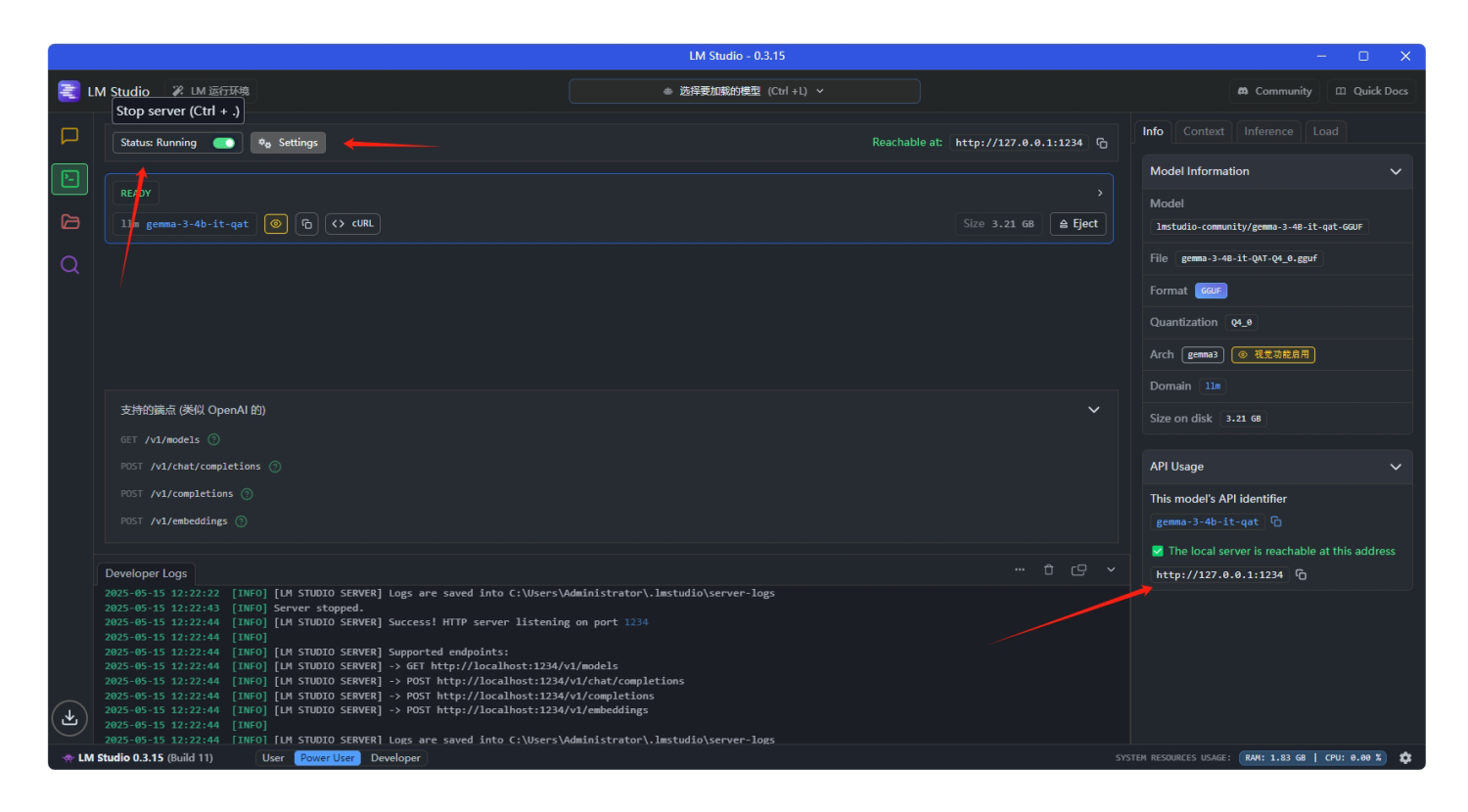

在 LM Studio 中设置本地 API 服务非常简单,它内置了一个兼容 OpenAI API 结构的本地 HTTP 接口。下面是完整的设置流程。

一、启动 LM Studio 的本地 API 服务

1. 打开 LM Studio

下载地址:https://lmstudio.ai/(支持 Windows / macOS)

2. 加载本地模型

3. 启动 API 服务

二、API 配置说明

| 项目 | 内容 |

|---|

| Base URL | http://localhost:1234/v1 |

| API Key | 任意字符串(LM Studio 不校验) |

| 协议标准 | 兼容 OpenAI Chat Completions API |

三、测试请求(命令行)

curl http://localhost:1234/v1/chat/completions \

-H "Authorization: Bearer any_key" \

-H "Content-Type: application/json" \

-d '{

"model": "mistral",

"messages": [{"role": "user", "content": "你好"}],

"temperature": 0.7

}'

model 需填写你当前加载的模型名称,如 mistral,gemma, llama3 等(在 LM Studio 界面中可看到)

四、集成到支持 OpenAI API 的程序中(如 KrillinAI)

[openai] apikey = "any_key" base_url = "http://localhost:1234/v1"

如果你使用的是如 KrillinAI、LMDeploy、LangChain 等工具,只要支持 OpenAI 格式,就能直接连上 LM Studio 本地模型。

补充:常见问题

❓Q: 启动 API 后访问无响应?

- ✅ 请确认模型已加载,并点击了 “Status: Running”

- ✅ 确保防火墙没有拦截 1234 端口

❓Q: 能远程访问吗?